立体双目虽然一直处于非主流的地位,但仍有不少铁杆支持者。

丰田、奔驰、本田、吉利、华为、博世、捷豹路虎、Rivian、铃木、斯巴鲁等都是这一方案的拥趸。

在造车新势力当中,小鹏汽车新一代智能驾驶系统 XPILOT 4.0 也将投入立体双目阵营,改款的 P5、P7 乃至中大型 SUV G9 都会采用这一方案。

无独有偶,2021 年 8 月,小米收购的 Deepmotion,其创始人兼 CEO 蔡锐、CTO 李志伟、首席科学家杨奎元和研发总监张弛,均是亚洲微软研究院出身,是微软 Hololens 项目算法核心人物。

而微软的 Hololens 项目,就是微软在 2015 年的 AR/VR 眼镜,核心就是立体双目视觉。从这个角度看,小米的智能驾驶大概率也是以立体双目为核心。

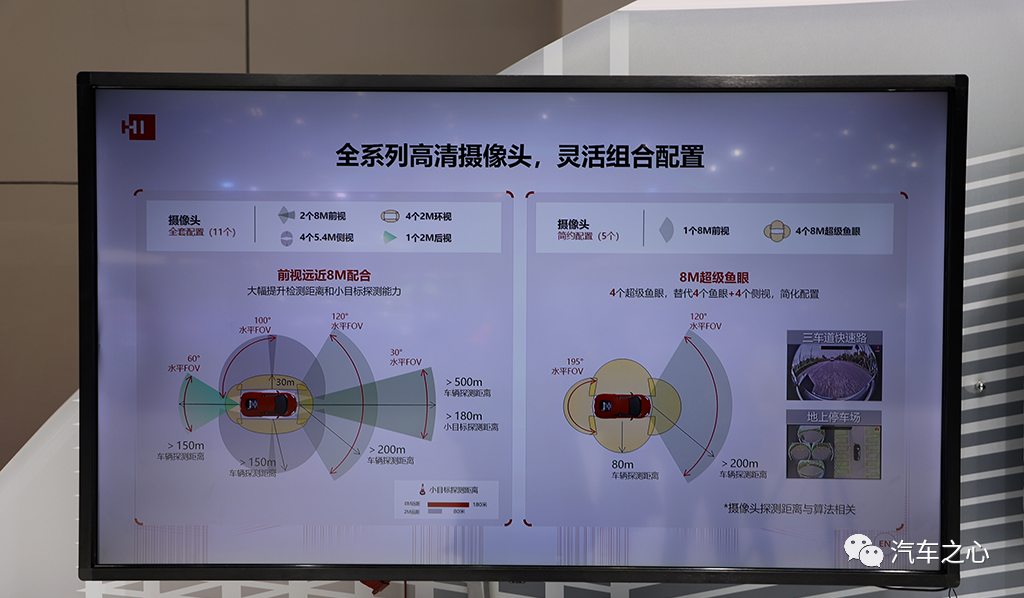

华为自动驾驶主要传感器是 800 万像素的立体双目摄像头和转镜式高线激光雷达。

在极狐 αS (华为 HI 版)的前风挡玻璃下,有 4 颗摄像头,最两侧是立体双目 800 万像素摄像头,中间是 540 万像素 100°水平 FOV 摄像头,负责车前侧。

如上图,华为 800 万像素立体双目的水平 FOV 是 60°,但是对单个摄像头是 30°。

这个较窄的 FOV 使得探测车辆有效距离高达 500 米,小目标如行人或儿童乃至角锥是 180 米。

吉利即将上市的 KX11/EX11 平台,也就是星越 L(KX11)和领克 07/09(EX11),顶配都将使用刚刚被麦格纳收购的 Veoneer 的第四代立体双目系统。

网上图片绝大多数都是低配的单目系统,单目系统也是 Veoneer 的第四代单目,上图是少见的顶配立体双目车型。

小鹏和小米以及一系列自主品牌转向立体双目的原因有三点:

1)立体双目比特斯拉为代表的单目、三目系统在安全性具备压倒性优势。

2)立体双目可以自主掌握核心机密,而不是人人都可以轻松玩转的深度学习。

比如国内大部分新造车势力都是用英伟达的方案,英伟达提供了全套软硬件乃至数据集。但英伟达也留了一手,无论是 Xavier 还是 Orin 都针对立体双目做了硬核对应,也就是双目立体匹配硬核功能区。

立体匹配只是双目的第一步,具体立体视差图深度图的应用也是核心技术,但英伟达并未参与,给车企留下了足够的发挥空间。

3)立体双目可以弱化对激光雷达的需求,降低成本。

图像识别与探测一体无法分割

由于硬件厂家的误导,让普通大众以为算力与安全性成正比、与技术先进度成正比。

实际上,这毫无任何直接关联,原因在于我们通常说的算力都是 AI 算力,也就是深度学习算力,更准确地说是卷积部分乘和累加的运算。

基于单目或三目的机器视觉,有着天然的无法改变的缺陷,这个缺陷表现为识别或者说分类与探测是一体的,无法分割,特别是基于深度学习的机器视觉。

也就是说,如果无法将目标分类(classification,也可以通俗地说是识别 recognition)就无法探测。

如果无法识别目标就认为目标不存在,与盲人无异——车辆会认为前方无障碍物,然后不减速直接撞上去。

什么状况下无法识别?有两种情况:

第一种是训练数据集无法完全覆盖真实世界的全部目标,能覆盖 10% 都已经是很不错了,更何况真实世界每时每刻都在产生着新的不规则目标。

特斯拉多次事故都是如此,比如在中国两次在高速公路上追尾扫地车(第一次致人死亡),在美国多次追尾消防车。

第二种是图像缺乏纹理特征,就像摄像头面前放一张白纸,自然识别不出来是什么物体。

某些底盘高的大货车的侧面在某一时刻或者一堵白墙,就是白纸一样,基于深度学习的机器视觉此时就如同瞎子,不减速就直接撞上去。

此外,静止目标对深度学习也是一个棘手的问题。

为了提高识别效率,机器视觉尤其是基于深度学习的机器视觉,需要先框选出运动目标,同时也为了防止误判,必须将运动目标和静止目标分开。

例如,有些道路两侧停满汽车,运动目标的优先级自然高于静止目标,然后再去识别,通常是背景减除、三帧法或光流法,有时需要 1-2 秒时间,然而事故可能就发生了。

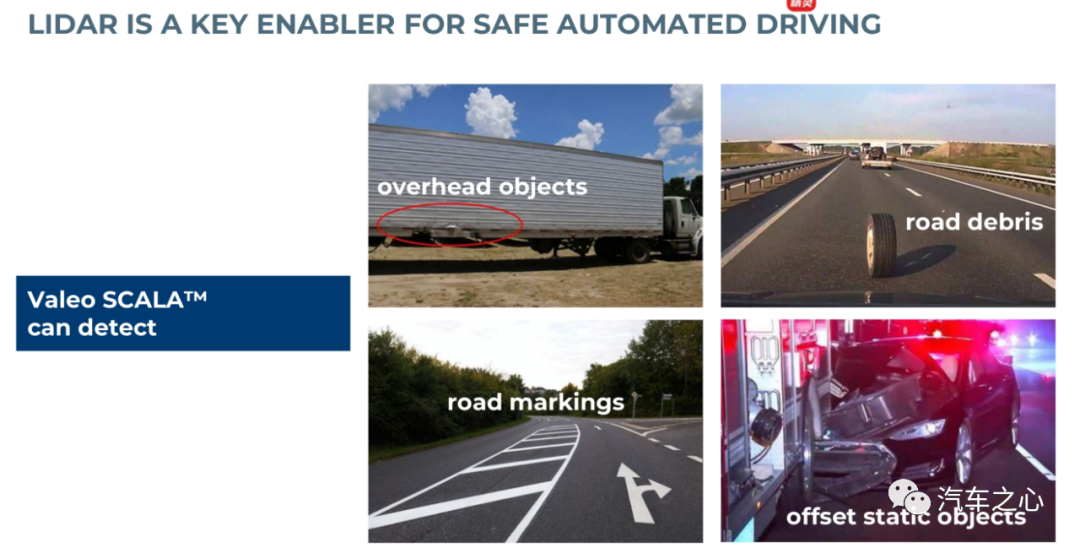

这个问题的解决办法,需要传统非深度学习算法,特别是立体双目和激光雷达,可以做到不分类也能探测目标的信息,无法识别就变瞎子的问题可以完美解决。

不过,这些技术掌握在丰田、奔驰这些真正的顶级大厂手中。

特斯拉在美国撞上翻倒的静止的卡车

从本质上讲,深度学习是一种高度通用且极为强大的曲线拟合技术,能够识别出以往无法被发现的模式,推断趋势并针对各类问题给出预测性结果。

当然,曲线拟合在表示给定数据集时也存在一定风险,这就是过度拟合。

具体来讲,算法可能无法识别数据的正常波动,最终为了拟合度而将噪音视为有效信息,并且深度学习是个黑盒或灰盒,调参更像是艺术而非科学。

特斯拉在台湾撞上静止的侧翻的大货车

再有就是毫米波雷达,目前量产车的毫米波雷达角分辨率太低,对金属物体又过于敏感,为避免误动作,所有的毫米波雷达都会将静态目标过滤掉。

此外,毫米波雷达安装的角度也很低,遇上底盘比较高的大货车,可能会检测不到。

即将上市的宝马 iX 安装的大陆 ARS540 4D 毫米波雷达角分辨率高,且是目前唯一能真正测高度的毫米波雷达,不过滤静态目标。

即便毫米波雷达不过滤静态目标,以辅助驾驶的设计原则,宁漏检不误检,恐怕也不会启动 AEB。

特斯拉撞的静止消防车和警车不胜枚举,立体双目就不会出现这种情况,它无需识别也可以探测障碍物 3D 信息,还可以预测其行动轨迹。

图片来自丰田工业大学、电装、SOKEN 的双目研发成绩汇报

激光雷达的缺点是其点云比较稀疏,即便是最强的 Luminar 激光雷达也难以和 100 万像素的摄像头比。

再有就是不同物体激光反射率差别极大,同样距离下,可能一辆白色车能探测到,一辆黑色车就探测不到。

再比如交通指示牌,激光雷达对其反射回来的高强度回波非常敏感,容易在点云中形成「鬼影」和「膨胀」。这样的点云是不可用的。

还有空洞,「空洞」描述的是激光雷达对于近场低矮障碍物的探测在从远到近过程中「时有时无」的丢失现象。

障碍物原始点云「时有时无」会让感知算法难以连续跟踪,这容易导致智能驾驶的急刹车或频繁「减速加速」顿挫。

除了空洞,还有激光雷达行业内部的术语「吸点」,这就是在近距离跟车时,车牌是强反射目标,与车体的低反射目标容易混淆,测距不准,形成盲区,称之为「吸点」。

激光雷达数据的稀疏性与非结构化,导致传统算法无法适应,深度学习这种测不准的黑盒子算法将激光雷达深度信息的高精度造成了衰减。

摄像头的缺点是必须有足够的纹理特征,比如颜色完全一致的大货车侧面,平整的水泥路面等没有纹理特征的目标,单目摄像头会完全失效,等于盲人,就像看到了天空一样,目中无人。

立体双目虽然此时仍可以探测到目标,但深度信息准确度会下降。

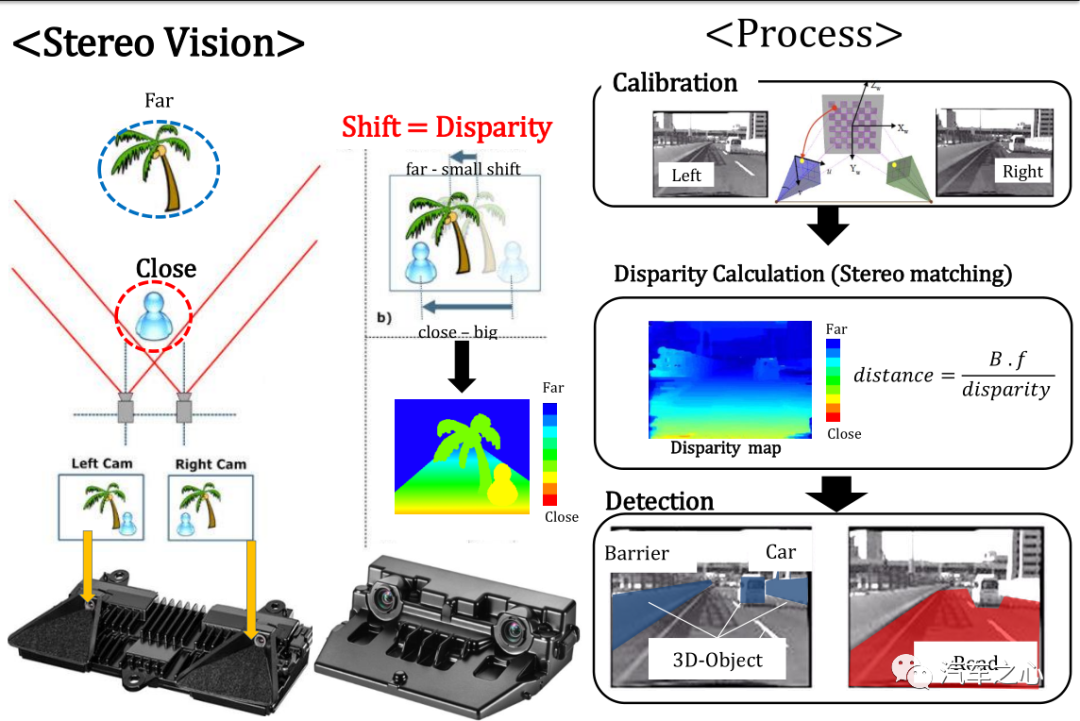

立体双目某种意义上也可看做一个激光雷达,其提供准确的深度信息,视差图可以转换为点云。

因此立体双目与激光雷达融合的效果最好,远比其他种类的传感器要好,单目通过深度学习可以估算深度,但准确度远不能和测量模式的立体双目比,两者有天壤之别。

当然,单目能做到的,双目也都能。

那为什么特斯拉不用立体双目?宝马用了立体双目为什么又退出了?

——原因是太难用了。

奔驰和丰田在这个领域花费了大量时间来研发。

奔驰早在 1999 年就投入双目的研发,2013 年才在 S 级上应用。

丰田大约也是 1999 年开始,直到 2019 年才开始在雷克萨斯上量产。

宝马照搬德国大陆汽车的全套立体双目解决方案,效果不理想,但没有大改款的宝马 7 系还是用的立体双目。

特斯拉这种短平快的公司自然不愿意多做技术累积。深度学习的免费资源很多,研发周期是双目的 1/10,甚至 2/30。

从事深度学习的人至少是双目的上万倍,双目人才奇缺,并且一切都要从头做起,几乎没有免费资源。

国内除华为外,只有中科慧眼能帮助车企量产立体双目系统。

电装最早的立体双目用于自动驾驶的研究论文发表在 2001 年。【1】

奔驰则是 1996 年,没有 20 年技术累积,很难用好立体双目。【2】

立体双目的后期处理算法几乎没有深度学习参与,大多基于纯几何的算法,这种人才罕见,一旦做成了,技术门槛很高,护城河很深。

而深度学习只需要大量投喂数据,用大型数据中心训练就可以,可以说除了资金门槛,没有任何技术门槛。

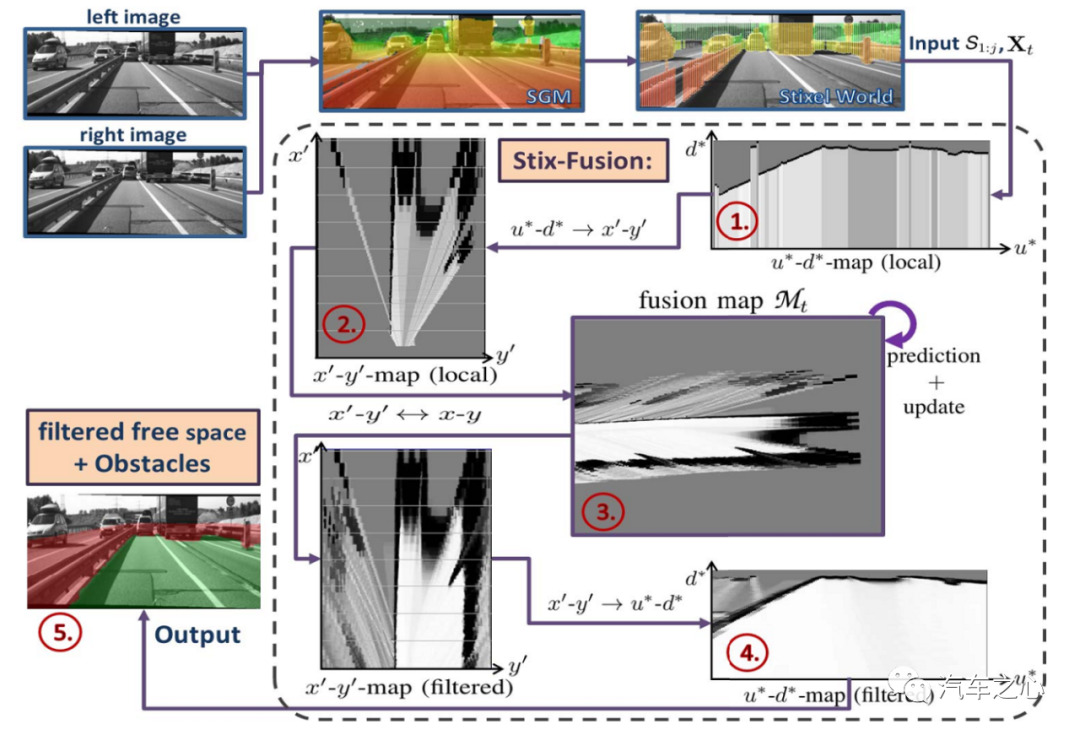

上图为奔驰的 Road Surface Freespace Segmentation 流程图,奔驰为缩小运算量,提出 Stixel 概念,Stixel 算法将物体抽象成立在地面上的一根根的 Sticks,。

这些 Sticks 将图片分割成 Freespace 与障碍物。

Stixel 是一个细长矩形,宽度固定 (3px, 5px,...),高度与障碍物相同。

本质上,Stixel 是一种超像素抽象,介于像素与物体之间,在性能和算法复杂度上比二者有着明显的优势。

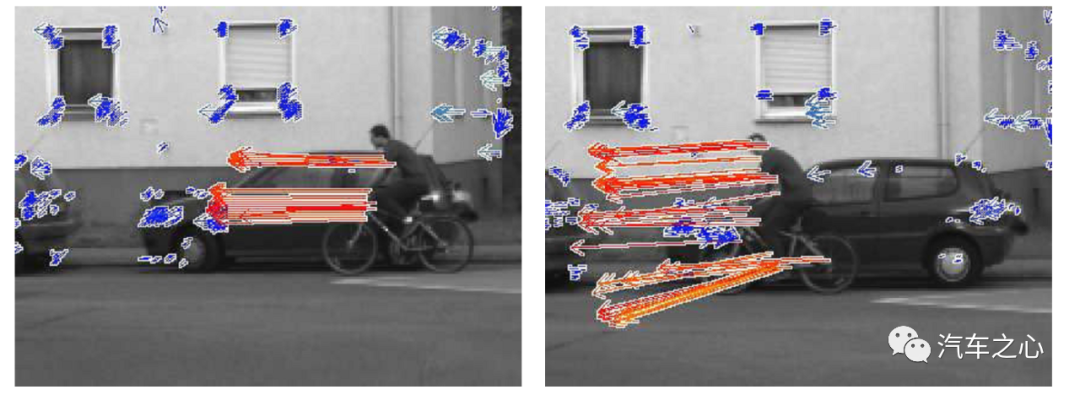

因为立体双目具备 3D 深度信息,因此光流法就比较适合立体双目,特别适合目标追踪。

当人的眼睛观察运动物体时,物体的景象在人眼的视网膜上形成一系列连续变化的图像,这一系列连续变化的信息不断「流过」视网膜(即图像平面),好像一种光的「流」,故称之为光流。

光流表达了图像的变化,由于它包含了目标运动的信息,因此可被观察者用来确定目标的运动情况。

丰田只用光流做自身位姿预测,实际就是配合 IMU 做 V-SLAM。

上图为奔驰的光流法,奔驰用 Stixel 降低运算量,在量产车上也用了光流追踪。图上箭头就是骑自行车人的 0.5 秒后的移动位置,右边是 0.5 秒后的景象,可以与预测位置做一个对比。

蓝色代表静态目标。不仅能追踪,预测位置,还能提供目标速度。

奔驰推荐四种光流算法,分别是稀疏 KLT、Patch KLT、Census 和稠密 TV-L1。KLT 和卡尔曼滤波器配合比较好,稠密 TV-L1 的精度比较高。

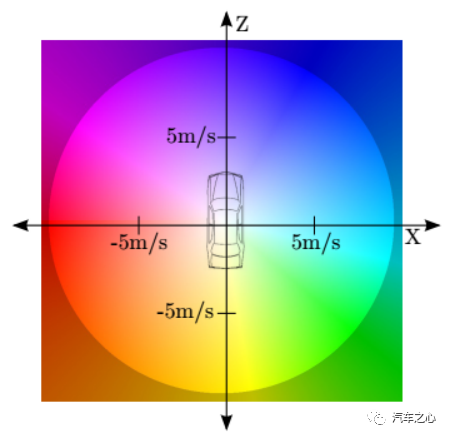

颜色编码示意图如左,不仅包括了速度还包括方位角,对移动目标位置预测非常有用。

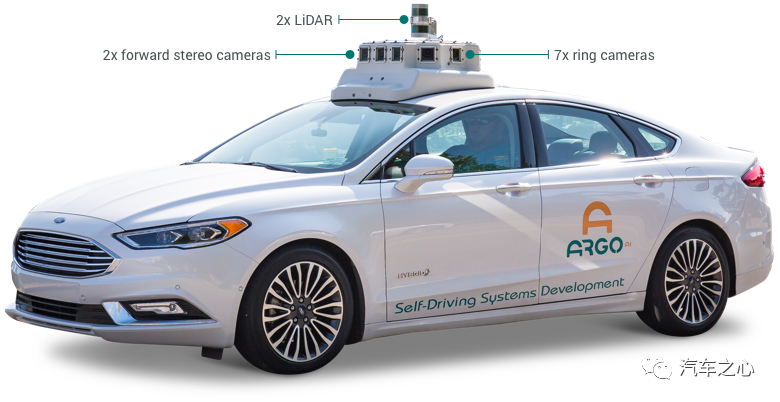

实际大众和福特也是立体双目的拥趸,上图是福特与大众合资的 Argo AI 的自动驾驶原型车。

路遥知马力,时间将证明丰田、奔驰、华为、小鹏的立体双目将会超越特斯拉。

相关阅读:

【1】电装相关论文:

https://www.denso-ten.com/business/technicaljournal/pdf/17-4.pdf

【2】奔驰立体双目相关论文:

https://ieeexplore.ieee.org/document/566403/authors#authors

论文作者 Uwe Franke 是现奔驰图像解析小组负责人,实际他最早的双目研究论文可以追溯到 1987 年,Uwe Franke 是当今立体双目界的权威。