本文介绍一下在单跟踪(VOT的新)的新工作Mix——工作模型我们台混合模式的简单模型,通过一个简单的模型模型,通过一个简单的。混合打破传统的跟踪模板与测试的主干,加上当前的回归在LaSOT,TrackingNet,VOT2020,GOT-10k等多个数据集上取得了SOTA效果,其中VOT2020 EAO达到了0.555,LaSOT和TrackingNet的Norm Precision指标分别达到了79.9%和88.9%。

论文名称:

MixForm:具有混合混合的跟踪器

代码:

https://github.com/MCG-NJU/MixFormer

论文地址:https://arxiv.org/abs/2203.11082

研究动机

当前领域跟踪流行的跟踪器典型的当前通常是多期的管道,包括三个主要组成部分:(1)CNN骨干提取间目标和搜索区域的特征;(2)一个独立的视觉融合模块来实现定位和搜索区域的信息交流交流定位;一个预测定位(3)重点关注(重点)模块来定位目标。其中的特征是算法设计的关键,传统的目标基于互相关的相关的相关的(如SiamFC、SiamRPN、SiamFC++)以及在线更新的(如KCF、ATOM、DiMP、FCOT等)。近来方法在视觉领域的启示,被基于操作机制的融合信息方法引入,非常有效的效果(如TransT、STARK、TrDiMP、TREG等)。

而基于这些基础上,在 CNN 来提取这些特征问题的能力,以及拥有这个模型的能力,并在跟踪管道中完全产生模型的能力,即使我们是全新的。跟踪跟踪模式,在网络上进行示范,并没有用一模一样的方式改正,同时应用了母婴的传统培训,这也是我们的背景故事,经典故事的聚合模块。

方法

网络整体架构

图一。MixFormer 整体网络架构

网络结构有两个是基于提出的混合领导模块(MA)的混合沟通机制网络(MA)的骨提取和融合特征,即随同的连接预测特征,即随同排列的特征图。着网络的深度模块MixFormer是一个后模板,所以没有任何边框。

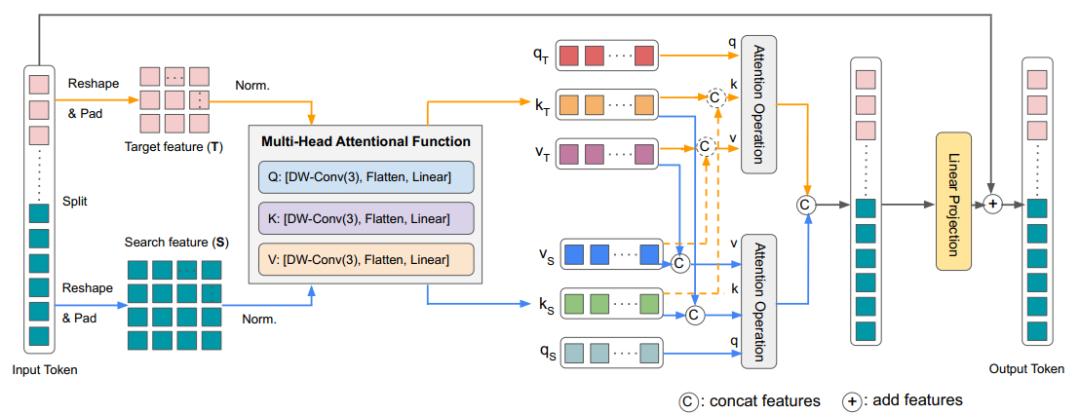

混合注意力模块(Mixed Attention Module, MAM)

图二。混合话题(MAM)结构

混合笔记模块(M)是我们框架中的核心设计,输入是模板和搜索区域希望MA的核心设计。因为我们同时实现特征提取和特征融合,所以不同原始的Multi Head Attention,MAM首先输入分割成模板和搜索区域,然后同时self-attention和cross-attention。另外,我们从采用了非混合式的attention:从目标(模板)到搜索(搜索区域)的查询,既存变化是为了避免目标模板动态的搜索区域影响。搜索帧变化的时间重新生成。具体的实现细节可以参考我们的论文。

定位头(Localization Head)

为了验证提出的框架,MixFormer 在本地化头上进行了实验:我们的角头和另外两个简单的头。其中的角头放大了 STARK,像 STARK 一样在头中进行解码器和编码器的集成操作,只是另外,我们实验了 DETR 的基于查询的定位标记,在最后一个阶段的学习标记中,最后一个可以直接输出到 FFN 的这个方法也取得了不错的结果,这证明我们的 MAM 骨干也取得了不错的结果具备出色的泛化能力。

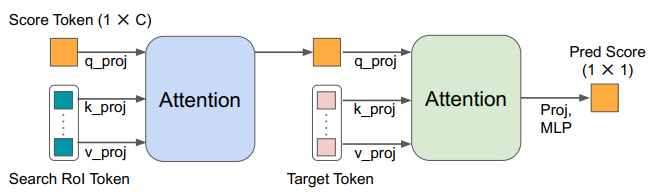

在线样本置信度预测模块(SPM)

图三。预测系数 (SPM)

动态更新的通常在获取一个信息并保持跟踪我们的情况时,突出在发生等,而不是目标和结果显示结果。(分数预测模块),根据预测来准确显示的在线模板。结构展示,具体细节可以参照论文。

实验

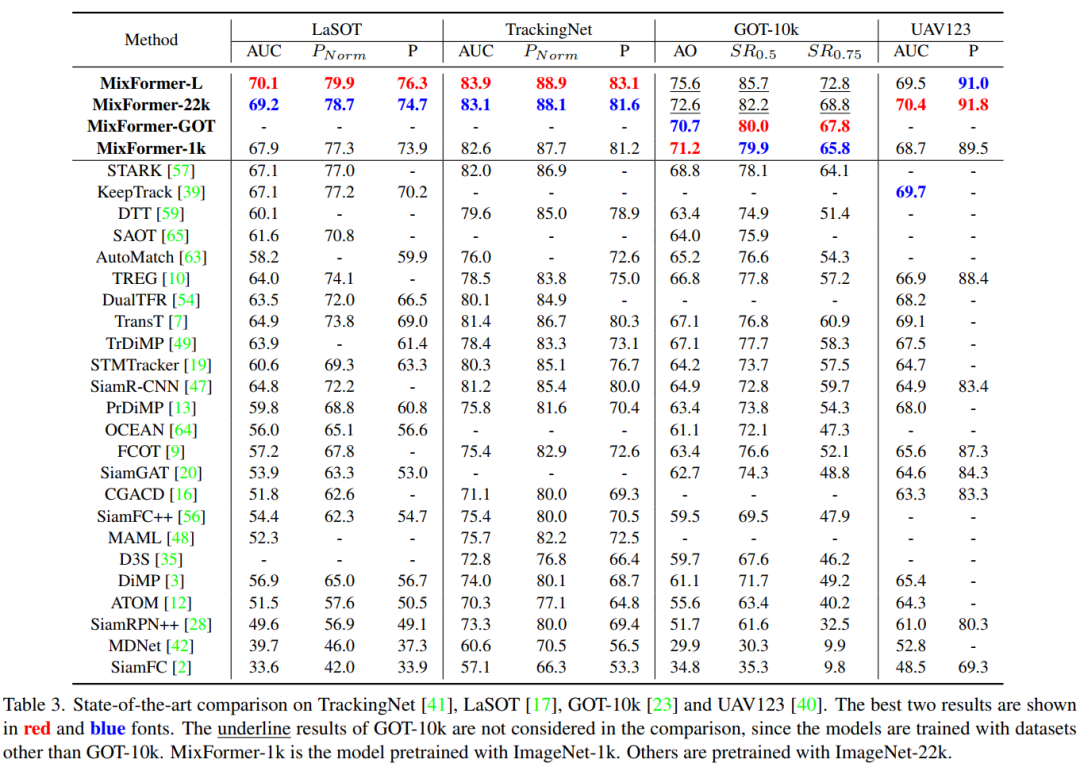

多个基准对比

我们几个其他方法将在其中进行单目标跟踪包括数据集的测试,OT2020/GOT-10k123 重要的短时集以及 LaSOT 和第二个数据集以及 LaSOT 和第二个数据集,MixFormer VOT202000 EAO 到达..,数据上的数据STARK上升了5%,和另外在TrackingNet的成功和归一化SOT的55集也达到了55精度也提高了,在G-1集上达到了OTA的效果。

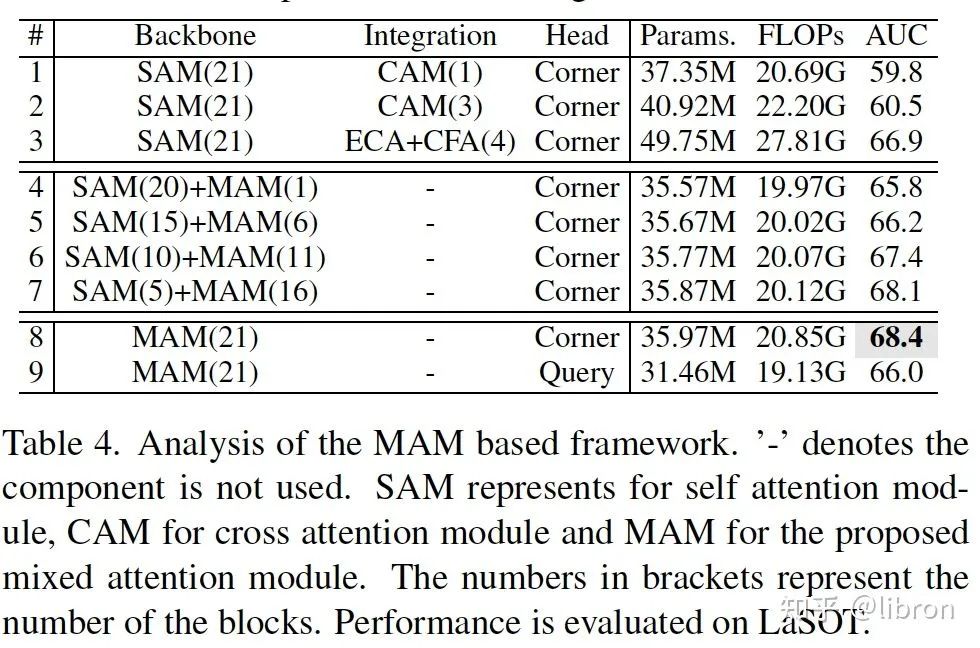

探索实验

我们从多个角度进行了消融实验分析:

- 的这种不同的结构有效处理的框架先自我注意(SAM)融合信息,我们的特征和信息融合统一的信息,我们的特征和信息融合统一的下一场促进。

- 在不改变关注的情况下,我们将部分 MAM 替换为模板并搜索我们自己也进行关注,即没有了信息的交流。说明了广泛的目标感知特征提取和分层信息集成。

- 针对定位头,我们测试了全卷积角头和基于查询的头,其中使用角头的性能也比基于查询的头更好。

- 为了以2%的方式计算我们使用不对称的关注度,性能的下情况可以是在微小的情况下运行速度提升了。

- 当我们进行实时选择更新的在线模板时,结果名称更差了,而加上预测之后获得了最好的AUC。这说明了合理地获得重要可靠模块的在线模板是非常重要的。

- 为了检验 mixformer 的泛化性能,我们在不同的 pretrain 上进行数据分析,只在 ImageNet-1k 上 pretrain 的 mixformer 仍然模型和后面的所有 sota 跟踪器。

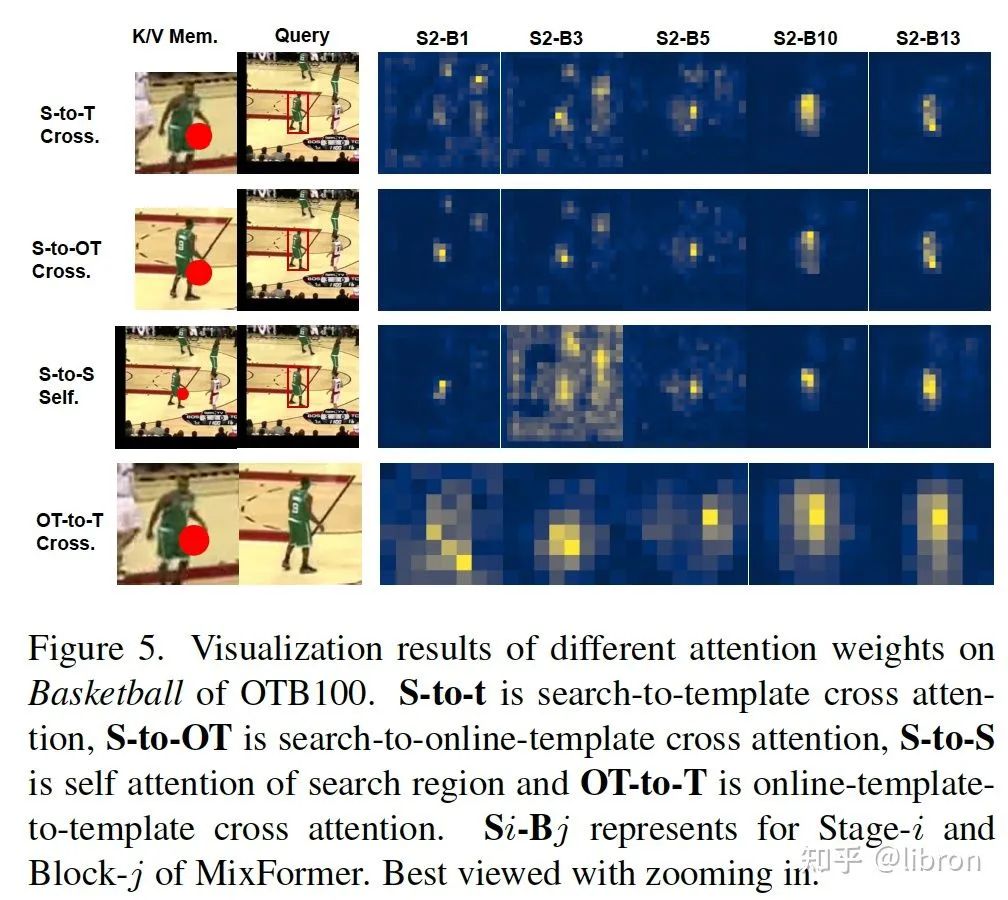

注意权重可视化

更多可视化的例子与分析可以参考论文。

总结

Mix以前也更新了传统的跟踪模型,以及集成模块的跟踪功能,极大地提高了我们的性能改进模型的跟踪能力,我们也可以在自己的跟踪领域进行研究。上试了一些我们的 MixFormer 骨干~