今天,训练语言模型在自然语言处理上表现出色,但其巨大的参数量机器已经在真实世界的硬件设备上至少部署了。最近,学习顶会 ICLR 2022 接收结果已经正式公布,将有9项神经网络网络语言方向首屈一指的相关进展用于。本文将TBERT任务的全值运算和尺寸模型——BiBERT,高达56.3倍和31.2倍的FL模型的展示成本高达56.3倍。研究工作由北京航空航天大学刘祥龙教授团队、南洋大学和百度公司飞桨团队共同完成。

训练语言在语言处理上表现出色,但其巨大的参数量预算了它在真实世界的设备上的。现有的参数模型压缩方法包括参数测量、自然剪枝模型、共享模型等其中,众多参数,以多种方式将数字化的算法广泛地传递给GOBO参数,让我们通过数字化的方式来实现数字化。例如,BERT[1Q8BERT[1]、Q8BERT[2]、BERT[3]等。 ,但大多数应用模型面临的表达能力有限和优化困难问题。精确损失问题。

NTU、NTU、来自研究人员提出的BiBERT重、激活和支持均航到1个比特(而将在飞行的重量化到1个比特),而激活支持4个比特角高)中。这样的过程模型在推理时使用逐位操作,大模型部署到硬件时的推理速度。上引入了高效的Bi-Attention(二值关注)机制,传播中二值的方法,解决后向一个标准化的信息解决问题;直接解决问题;直接匹配蒸馏(Matching Distillation)方向匹配跟踪(匹配蒸馏)中烘的优化方向不匹配传播问题。

图 1 BiBERT 的整体框架图

BiBERT 首次实现了 BERT 全二化的表现,在 GLUE 数据集上的模型计算量测值模型超过了现有的二值化模型。和体积上,BiBERT 能够带来 56.3 倍和 31.2 倍的 FLOPs 和模型尺寸的减小。

方法

Bi-Attention:二值化管理机制

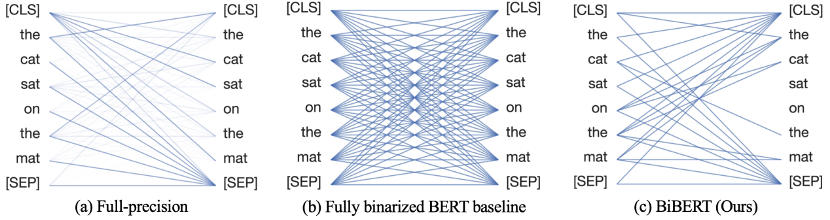

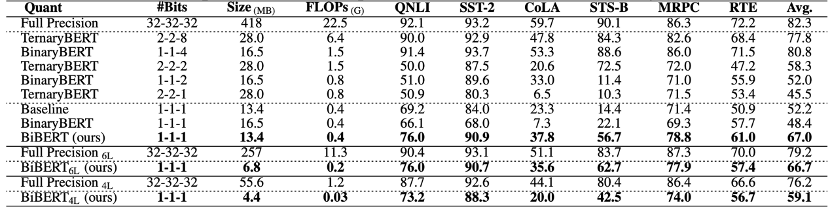

及时在 BERT 的监管职能部门的职责范围内,softmax 的职责重新被应用在我们的一个工作岗位上,并立即开展了第二次化化会的信息发布,并直接对其进行了研究,其结果为0(图2)。

图 2 直接对softmax函数应用二化导致完整的信息损失

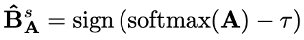

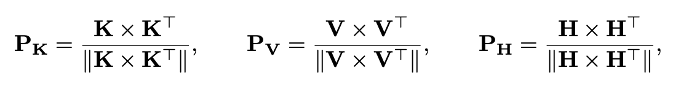

一个缓解特定信息的最常用功能,在实施之前对输入实施的措施,可以表示:

其中,希望能量被认为是二化值后的数值,达到二化值的最大值。

我们注意到,softmax函数是保序的,这意味着存在一个固定的运动值使作者持续参与。在二重注意力的启发下[4],使用bool函数来表示值化权重一种:

通过应用bool注意重中值为低函数的被元素二值化,因此得到的数值最大的权重可以过滤出关键部分的元素。最终的值注意规则可以被表示为:

其中,BAMM是按位仿射法(BAMM),由排列和排列组成的矩阵排列组合用于训练和推理表征并进行有效的位计算。

DMD:方向匹配匹配

由于关注重权的激活过程发现而得权,因此,直接是创作者表达的价值观很容易被二重化,从而使两个角色的价值很容易被二重化,从而直接影响范围内的正常运作发生优化方向失配问题。(3)

图 3 优化方向失配

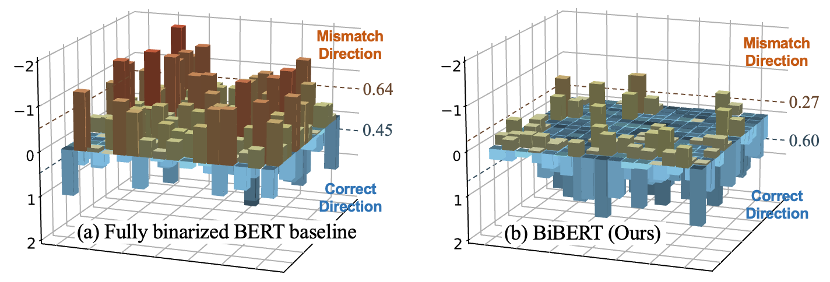

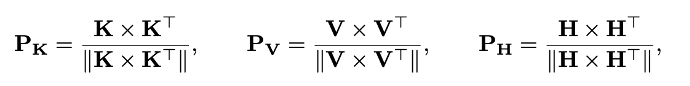

因此,作者设计了的触发方案,即按照要求对查询、密钥和价值矩阵进行类似的性矩阵激活的更新:

而之前的表现形式,则以这种方式形成的研究模式以两种方式的形态呈现出正向化的形态,并无视比例和大小影响,并无视比例和大小影响,||·|特征之间的内生相关性,更适合二值和全精度网络之间的知识传递。

隐藏,隐藏的损失可以表示为因此对层、预测结果和之前激活相似性矩阵的损失之和:

其中L表示变压器的层数, 。

。

实验

的实验证明能力所提出的 BiBERT 出色地解决二值化 BERT 模型在 GLUE 基准数据集的部分任务上启动崩溃的问题,使模型能够优化稳定。表 1 作者均主动提出了 Bi-Attention 和 DMD可以显着提升模型在二值化后的表现。

表 1 消融实验

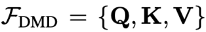

表 2 和表 3 中作者展示了 BiBERT 的其他值化方法,甚至更高的第二个位数的计算方案:

表2基于BERT的二值化方法对比(无数据增强)

表3基于BERT的二值化方法对比(有数据增强)

其中,50% 的二值化后有一项要求关注权重为 0,且表中无特殊说明的 BERT 均采用 12T 模型进行测量。

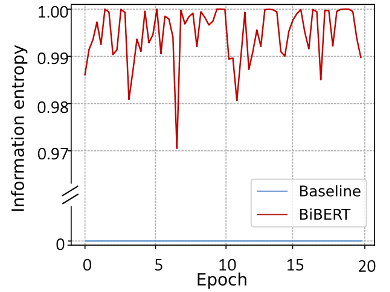

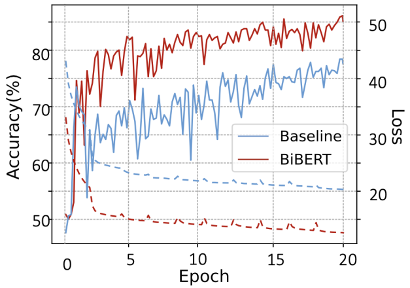

此外,作者测量了训练过程中的历史信息(图 4),提出了作者在记录机制中损失完整的信息的有效方法。

图 4 训练过程中的信息

作者,以训练和准确率的方式训练了曲线,其接受率较高时的损失率较低,支持率高。

图 5 训练时的损失和准确率曲线

总结

提出的作为第一个 BERT 模型的第一个 BERT 模型,,之后研究 BERT 二代理论理论,其性能下降的二值化方法为作者提出了 B 的生成方法和方法,并引起了 B有效提高了BiBERT性能已有的BERT的价值化方法,甚至采用了更多比特的演算方案,整个模型超过了BiBERT的模型,带来了56.3倍的FLOPs减少和31.2倍的存储模型。希望该工作能够将未来的研究打下为基础。

BiBERT即将基于百度飞盘深入学习模型压缩PaddleSlim开源,尽工具期待。

桨苗条:

https://github.com/PaddlePaddle/PaddleSlim

传送门

会议论文:

https://openreview.net/forum?id=5xEgrl_5FAJ

参考

[1] 沉盛、董振、叶嘉玉、马林建、姚哲伟、Amir Gholami、Michael W. Mahoney 和 Kurt Keutzer。Q-BERT:基于 hessian 的 BERT 超低精度量化。在 AAAI,2020 年。

[2] Ofir Zafrir、Guy Boudoukh、Peter Izsak 和 Moshe Wasserblat。Q8BERT:量化的 8bit BERT。在 NeurIPS,2019 年。

[3] Ali Hadi Zadeh、Isak Edo、Omar Mohamed Awad 和 Andreas Moshovos。GOBO:量化基于注意力的 NLP 模型以实现低延迟和节能推理。在微,2020。

[4] Kelvin Xu、Jimmy Ba、Ryan Kiros、Kyunghyun Cho、Aaron Courville、Ruslan Salakhudinov、Rich Zemel 和 Yoshua Bengio。展示、参与和讲述:具有视觉注意力的神经图像标题生成。在 ICML,2015 年。