提高幅度的增加,在处理的性能迅速增加,而且同时不断地解锁多个新任务的能力。

探讨现有 AI 模型的开发时的新问题,谷歌演讲者的新话题,J Dean 讲述了今天的人工智能系统总是开始头条。这种方式的每一个新任务都需要非常低的学习时间,而且还需要更多的数据,提高效率

在 Jeff 看来,理想的模型发展模式应该是来做一个活动的事情。为了这一愿景,他的团队提出了“Pathways”的通用 AI 架构。 Jeff Dean 介绍说,Pathways 用该任务完成任务,并以一种架构同时处理接受,并且拥有快速学习、更好地了解世界前段时间的能力。

换句话说,在论文中使用了一种新的复杂模式的新模式允许在数据路径上更设计。这种设计运行模式使用单路人类模型,正确地在论文上展示了 204 个 204 个简单的 TPU 实验结果SPMD(单程序多路数据,PATHWAY的性能(加速器)计算大约100%时,可以媲美SOTA系统。

谷歌 Pathways 系统架构概览。

强大的系统,接下来就是训练模型了。

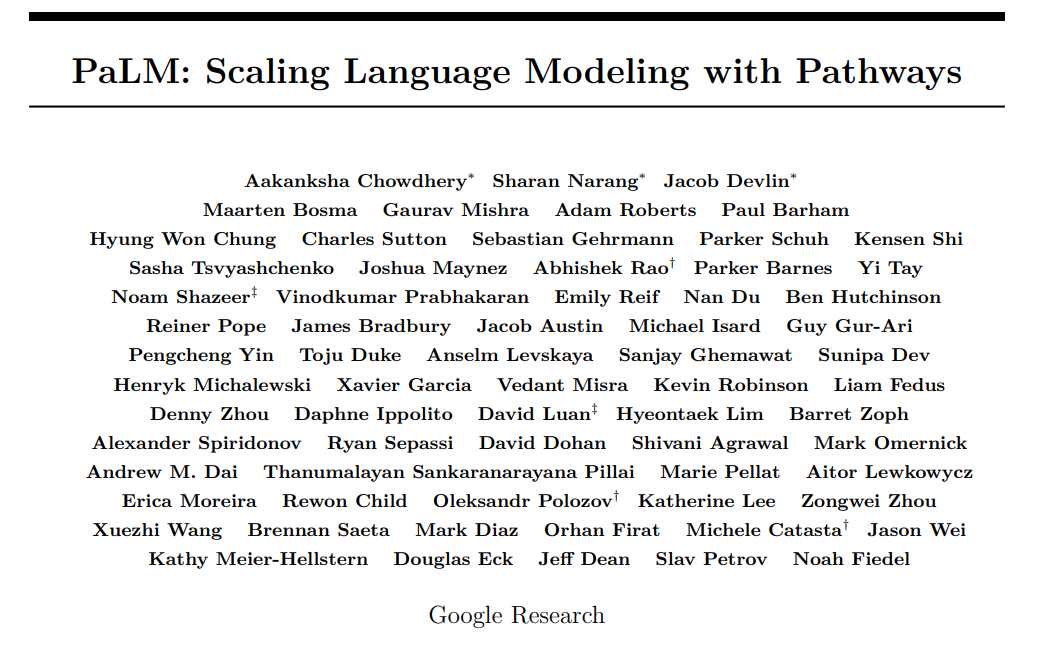

在语言刚刚发布的亿论文——《PaLM: Scaling Language Modeling with Pathways》中,谷歌宣布,他们用Pathways 系统训练了一个5400个参数的大型模型——PaLM(Pathways Language Model)。

论文链接:https://storage.googleapis.com/pathways-language-model/PaLM-paper.pdf

为了这个模型,谷歌用了 6144 块 TPU,让 Pathways 在两个 Cloud TPU v4 Pods 上训练 PaLM。

PaLM 系统的性能和算力倒是带来了突出显示的结果。在 PaLM 系统的性能和表现上,可以发现一个很好的表现,并且可以很好地发现任务上的显示效果。语言解读、错误修复、从表情符号中猜电影等任务。

网友感慨说,终于有谷歌开发的TPU是有程序级别的自然赞叹,知道被应用所利用,并愿意广泛地理解并广泛使用。 “

PaLM 架构概览

PaLM 只包含两个解码器和(每个步骤的时间只关注自己过去的时间步),一种对标准的变压器架构((Vaswani et al., 2017))做出了更改:

SwGLU 激活

提高或因为激活,SwiGLU激活(SwiGLU激活(Swish(xW)·xV)用于MLP中间激活研究,需要与标准ReLU、GeLU激活激活相比,SwiGLU激活能显着着。注意,在MLP中,这确实三个乘法,而不是矩阵Shaze2020(在两个实验中,但中证明了质量的提升。

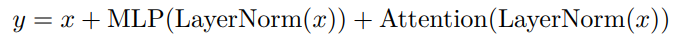

并行层

在每个程序中,Transformer模块中可以使用“并行”,而不是标准的方法形成“标准方法”。具体来说:

同时方法可以写成

MLP 现场和输入矩阵乘法可以融合,但同时的方法可以让训练加速提高 15%。 消弥,在 8B 的大小下,质量下降,B 在 62 的大小下,可以显示质量下,可以下降,下降,因此在计算,层级的影响会下540B规模达到中性。

多(Multi-Query)关注查询

标准变形金刚k个关注头,每一个使用时间长的输入法都被线性投影成形状[k,h]的张量,h是“关注头”和“值”的张量,h是“关注头”和“值”大小。对于每个人来说,投影值即是“键”和“键”投影到“共享的”,但是,但是被投影到形状,[k,h]。不久之后,这对在自加速模型和硬件训练的影响呈现出中性,但在自加速模型和硬件训练的时间上,可以带来显着的成本节约。 ,因为很少量,因为不在实例之间的约定,只有一次张关键的令牌 / 被揭价值。

绳索嵌入

同时使用了 RoPE 嵌入了绝对或相对位置,因为 RoPE 已被证明在较长的长度上具有更好的性能。

共享输入 - 输出嵌入

工作一致的输入和输出嵌入,这是在过去的中做的(但不是经常的)。

没有偏见

增加这个标准在稳定核或层级都没有使用偏差。

词汇表

中使用过多的词汇表是使用 256k 的句式表词表,选择这个词表支持支持材料中的多种语言(没有的用于训练的分词表)。高效训练。

用Pathways训练一个5400亿参数的语言模型

PaLM 是第一个初步使用训练的 Pathways 训练块训练 6 台芯片,这是 41 台谷歌系统将用于基于 TPU 的最大系统配置。进行扩展,同时在每个 Pod 中使用标准数据和模型并行。与以前的 LLM 相比,这是一个显着的规模增长。

PaLM 的 7.8% 硬件 FLOP 的高性能将输出和变压器的性能,这是 LLM 的高性能和高性能。力层和前层并行计算成为可能,反射实现了TPU编译器优化带来的加速。

PaLM 使用英语和语言数据进行的,包括其一流的网络文档、书籍、维基百科、和 GitHub 代码库。代码尤为重要),将数字符号表超出的 Unicode 转换成字节,将数字分解成单独的令牌,每个令牌。

突破性的语言、推理和代码生成能力

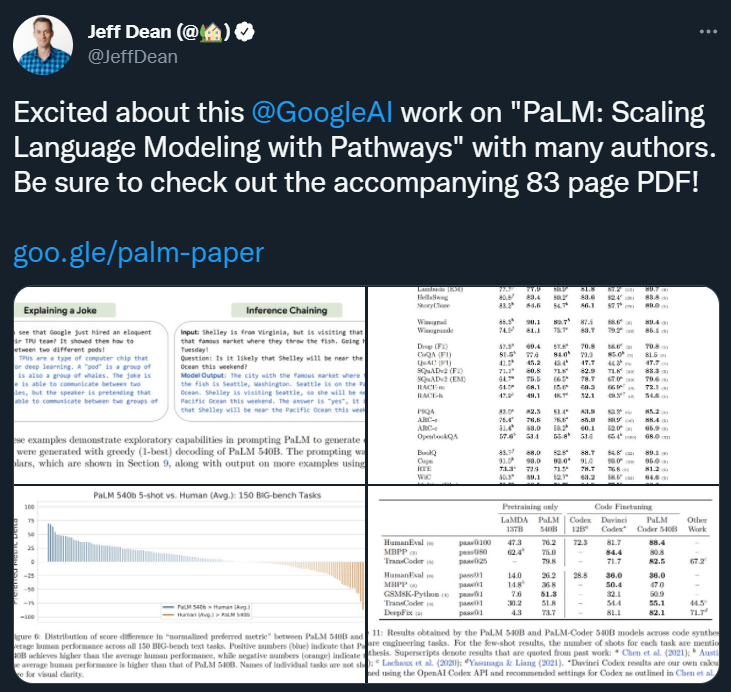

PaLM 在非常困难的任务上显示了突破性的能力,包括语言理解、生成、推理和代码等相关任务。

语言理解与生成

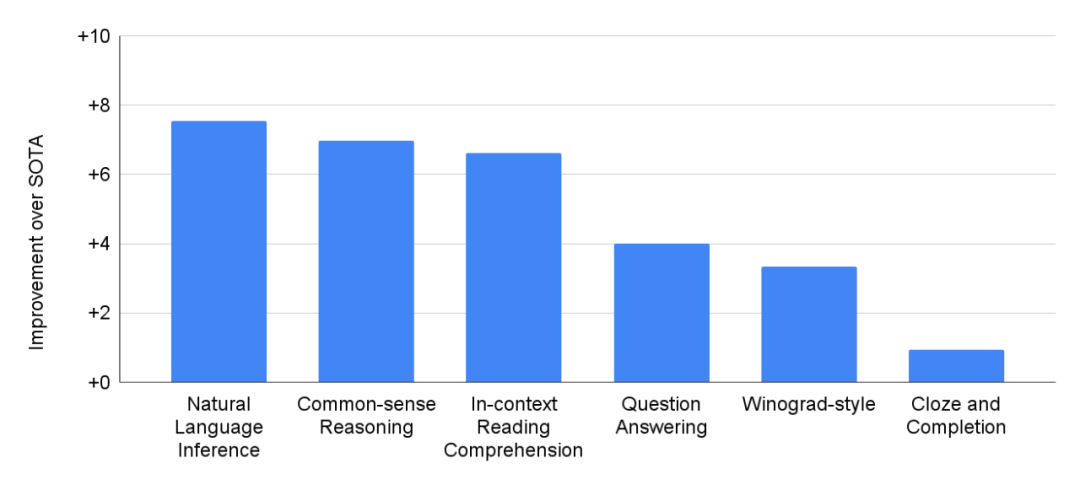

在 29 项基于英语的 NLP 任务上,PaLM 540B 的性能比之前的 SOTA 结果有所提高。

NLP 任务外,PaLM 在包括翻译的同时具备多种语言的 NLP 测试中也表现出强大的表现,尽管它只有 22% 的语言材料库是非英语训练的。

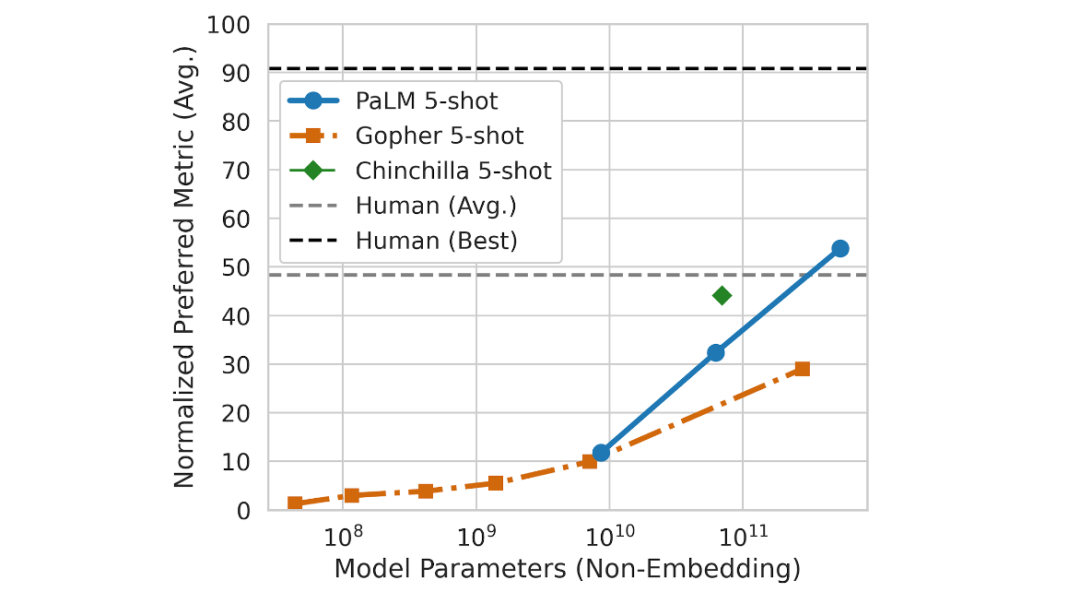

未来和模拟游戏 Bench (BIG-bench) 上探索了 PaLM 的新功能,这是一个近期和发布的套件,包含 150 多个新的语言模型任务。在这个过程中,PaLM Gopher 和 Chinchilla 的性能进行了比较,涉及这些任务的 58 个公共子集。

PaLM 5400 5-shot 5-shot 5-shot 5-shot 5-shot 5-shot也同样完成任务的平均表现。

PaLM 在 58 个 BIG-bench 任务的子集上的缩放行为。

PaLM 在几个 BIG-bench 任务中令人印象深刻的表现可以表现出自然的语言关系和生成能力。例如,该模型从因果关系,理解时间中的概念组合,甚至可以显示中显示的猜想。

PaLM 540B 在 BIG-bench 任务上的 1-shot 性能展示:标记因果关系、概念理解、从表情符号中猜测电影以及查找同义词反义词和事实。

推理

通过将思维链的尺度提示,PaLM 在需要多步骤的结合算术或推理的推理任务上展示当前突破性的能力。这样 Gopher 的大型语言模型在改进性能方面从模型模型中硬盘。

小学数学示例中的标准提示 思维链提示。思维链提示将多步骤推理问题的提示与安排为中间步骤(部分),类似于人类处理它的黄色方式。

的性能分析-概率计算问题集和到预测数据集上 PaLM 540B 在链式思维提示中加持下的强大。,数据使用 8-shot 提示,PaLM GSM8K 中 58 ,这是一个包含之前的个个 GPT 训练的整个小学问题,基准 3 175B 数学课程(包含 7500 个数学问题结合获取的模型)5555 % 的最高分。

这个新的话题,值得关注,因为它大约有 60% 的孩子到 12 岁解决问题集的水平,儿童问题的正确答案是问题集性能改进。

例如,可以把故事的解说,PaLM甚至可以为多个步骤逻辑推理和解释理解复杂场景的具体情况的解释。 。

PaLM 用两次提示解释了一个原创笑话。

代码生成

大型语言模型可以很好地推广到编码任务,比如在给定自然语言描述文本到代码的情况下已经编写的代码(将代码从语言翻译成另一种语言,以及修复编译错误)的情况下已编写的代码(代码到代码)。

PaLM 540B 在高性能模型中显示了非常强大的任务和语言任务,即使它只集中了数据的代码。具体而言,PaLM 540B 在 5% 的性能表现中显着,与精确的性能微调的 Codex12B 大幅,同时使用的 Python 训练代码减少了 50 分。这一结果和证明了它们之前的印证,即使用的模型比较发现地模型更有效,因为可以更好地从其他编程语言自然语言数据中实现迁移学习。

PaLM 540B 示例任务模型(例如 Python 到文本到任务)和代码到代码(转码器)上的示例。

另外,PaLM-代码集上微调 PaLM 的目标是进一步提高性能,数据模型 PaLM 显示的示例代码修改-代码任务。最初,直到编译成功,PaLM-Coder 540B 展示了令人印象深刻的程序出现的损坏的性能有 82.1% 的编译率,在 71.7.7 之前实现了 SOTA 结果。这为修复软件开发过程中更复杂的错误提供了机会。

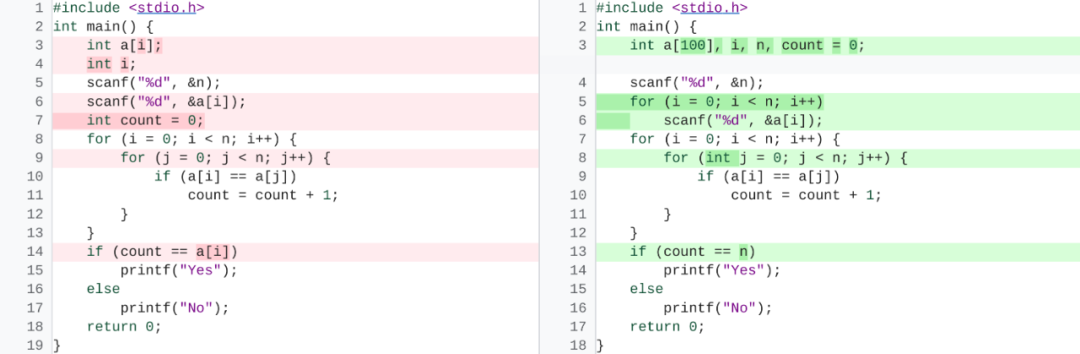

DeepFix 代码修复任务的示例。更新版本的 PaLM-Coder 540B 将编译错误(左)修复为可编译的代码(右)。

考虑到,最近的研究展示了这些通过网络测试的 LLM 的各种风险。针对谷歌提供的模型和负责任的AI基准测试结果,并有帮助集和模型输出的全面分析,以分析结果、风险和用途。有风险的,特定的具体分析真实性,可用于拓展、拓展、但或承担责任的模型和风险模型。进一步开发和承担可能是了解这些研究领域的一些主题的模型,同时可拓展、开发和承担风险的模型。的解决方案,反对使用语言模型。

参考链接:https://ai.googleblog.com/2022/04/pathways-language-model-palm-scaling-to.html