作者:左鹏飞,华为云AI存储首席架构师

地址:

https://zhuanlan.zhihu.com/p/1991153206219257611

经授权发布,如需转载请联系原作者

两周前,我在华为公司内部的稼先社区主办了一个主题为“下一代大模型推理系统创新”的 TED 论坛,向大家分享了我们团队在2025 年所做的推理系统技术创新。趁着元旦假期,我整理了对应的文字稿,以此作为 2025 年的年终技术总结。

引言:推理爆发元年,千亿成本之战

回望 2025 年,我们不仅经历了技术的迭代,更见证了产业格局的巨变。如果说过去几年是“大模型训练”的军备竞赛,那么 2025 年无疑是“推理业务爆发”的元年。 随着模型能力的成熟和 Agent 应用的落地,云端算力的天平发生了根本性倾斜:目前云上绝大多数 GPU/NPU 资源已被推理业务占据,服务于推理的加速卡规模往往比训练卡规模高个好几倍,有些公司甚至高一个数量级以上。

对于任何一家 AI 公司而言,最大的成本中心往往是 AI Infra。而在 Infra 的版图中,随着用户量的激增,推理成本占据了压倒性的比例。这意味着,推理系统的效率优化不再仅仅是技术极客的自我挑战,而是直接关乎企业生存与发展的“生命线”。试想一下,如果能通过系统架构的创新,在相同硬件规模下将推理吞吐提升 1 倍,对于一家算力投入巨大的科技公司而言,这可能直接对应着高达数百亿人民币的成本节省。

正是这种巨大的商业价值与技术挑战,驱动着我们团队在过去一年里不断探索推理系统的边界。2025 年,我们见证了 DeepSeek-V3 系列将 MoE 推向极致,看到了 Agent 应用从 Demo 走向复杂的生产环境,更亲历了 Context Caching 从“屠龙技”变成“大路货”。当传统的推理系统架构(如早期的 vLLM, TGI)逐渐显露出疲态,单点优化(Kernel Fusing, Quantization)的边际效应递减时,系统级的架构重构成为了新的增长引擎。

本文将复盘驱动我们推理技术创新的四大关键趋势,并详细解读我们团队在 2025 年最具代表性的五项工作(SparseServe, Adrenaline, TaiChi, DualMap, MemArt),希望能为社区提供一份有分量的技术答卷。

01 驱动推理系统创新的四个关键趋势

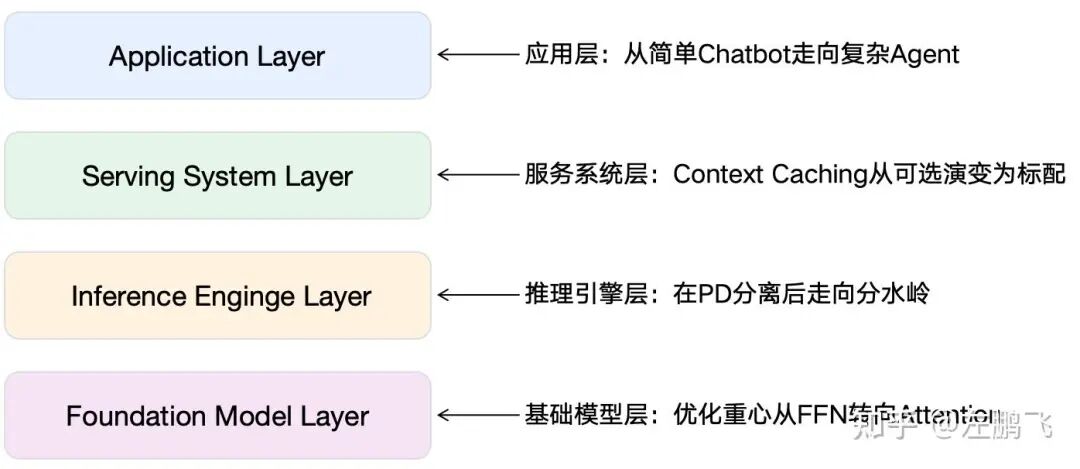

在介绍具体工作之前,有必要先回顾我们今年看到的“风向”。正是这些底层的变化,决定了我们为什么要做这些研究。如图 1 所示,我将这四个趋势映射到云上推理服务的四个层次。

趋势一:应用层——从简单 Chatbot 走向复杂 Agent

现象:LLM 应用的形态发生了质变。在 2023-2024 年,推理面对的主流负载是 Chatbot(如 ChatGPT)。这类应用的特点是输入输出比较为均衡,通常在同量级(如 3:1 ~ 1:3 之间)。但在 2025 年,LLM 应用演进为复杂 Agent(如DeepResearch),具备“规划—工具调用—执行—反思“闭环,在多步骤任务中持续读取环境信息、调用工具并迭代决策。这导致 Input/Output Token Ratio 激增至 100:1 甚至 1000:1。

挑战:1)Prefill 占主导:端到端延迟和成本不再由 Decode 决定,而是由 Prefill 决定。2)Memory 成为关键因子:Agent 需要跨任务、跨会话地“记住”用户的偏好和状态。如何有效表征、管理和检索这些Memory,提升推理准确率和效率成为关键。

趋势二:服务系统层——Context Caching 从“可选”变为“标配”

现象:在多轮对话与 Agent 工作流下,线上请求的 Prefix 重复率显著升高:系统提示词、工具说明、固定模板与会话背景会在同一任务链中反复出现。每次从零做 Prefill,会把 Agent 的高输入输出比特征直接转化为重复计算与高成本。因此 Context Caching(前缀缓存) 成为了各大厂商(OpenAI, Anthropic, DeepSeek, Google等)的标配功能。

挑战:缓存引入了“状态”。在无缓存时代,请求是无状态的(Stateless),调度器可以随意将请求分发给任意空闲节点(Round Robin 或 Least Loaded 即可)。但引入缓存后,为了命中缓存,调度器需要将请求发送到持有该前缀数据的特定节点,这被称为 Cache Affinity(缓存亲和性)。这就引出了分布式系统中最棘手的 “亲和性 vs 均衡性”矛盾:1)追求亲和性,会导致某些存有热门前缀的节点过载(Hotspot),产生长尾延迟。2)追求均衡性,强制打散请求,会导致缓存无法复用,计算资源浪费。

趋势三:推理引擎层——Prefill–Decode 分离后的优化走向分水岭

现象:早期 LLM Serving 多采用 PD 耦合,将 Prefill 与 Decode 放在同一资源池,通过 Batching、调度与算子优化压榨资源利用率(如 Orca)。随着推理服务开始同时约束 TTFT/TPOT,业界逐步转向 PD 分离,以减少 Prefill 和 Decode 之间的时延干扰。

挑战:PD 分离后出现资源利用率的“双重浪费”。Prefill 侧算力忙,但显存容量和带宽利用不足;Decode 侧 KV 常驻导致显存容量和带宽吃紧,但算力不饱和。于是“资源利用率低”成为关键矛盾。 这时候,推理引擎的优化走到了十字路口:1)异构部署,比如采用算力强显存弱的卡跑 Prefill,算力弱显存强的卡跑 Decode,沿着这个思路甚至可以继续把 Decode 的 Attention 和 FFN 拆开(AF 分离)也部署到异构卡上继续提升弹性和利用率(如MegaScale-Infer)。但是异构卡部署在云数据中心往往会遇到异构资源不可获得、高性能网络难互通、弹性降低等挑战。2)分离混部,逻辑上仍分离,但在执行路径上跨阶段混部,比如将算力密集型和内存密集型的推理子阶段混合部署到相同卡上以提升资源利用率。

趋势四:模型层——优化重心从 FFN 转移到 Attention

现象:在 FFN 侧,DeepSeek 将大规模小专家 MoE 路线跑通后,基础模型在 FFN 结构上逐渐收敛到高稀疏 MoE架构(如 DeepSeek-R1/V3 系列、Qwen3-MoE 系列、Kimi-K2 等),推理计算量大幅下降。然而,随着 Context Length 突破 1M,Attention 层的O(N2) 计算复杂度和O(N) 存储复杂度成为了新的恶魔,因此 Attention 优化成为新的主战场。

Attention 的优化主要就是做 KV Cache 的压缩,DeepSeek 提出的 MLA 把每 Token的KV 在 Head 维度压缩到极致以后,Token 维度的压缩成为新的战场。目前看,Token 维度的压缩主要有两条路线:1)稀疏注意力:KV 仍保存,但做访问上的压缩,即每个 Token 只与最重要的一小部分 KV 交互,降低计算与访存带宽(如 DeepSeek-V3.2 的 DSA)。2)线性注意力:将对历史的依赖压缩为可递推的状态,使 Decode 更接近每 Token 常量开销(如 Qwen3-Next、Kimi Linear 等)。这两条路线也可混用形成混合注意力。当然,Token 维度也有其它压缩手段,比如把连续几个 Token 的 KV 压缩到一起,但是还没看到成熟的模型使用。

挑战:当模型Attention 结构发生变化后,必然会对推理系统的实现产生影响,系统瓶颈可能会发生转移,甚至某些模块需要重新设计。比如,我们发现动态稀疏注意力消减了大部分 Attention 计算后,Decode 吞吐的瓶颈从 HBM 带宽转移到 HBM 容量(KV 仍要常驻,batch size 更容易被容量卡住)。另一个例子是,在使用线性注意力后,模型状态不再是完整的逐 Token KV Cache,而是每层维护的 SSM ;因此传统的“前缀 KV 复用式 Context Caching”需要演化为“SSM Checkpoint/恢复”。在混合结构里,系统还要同时管理 KV Cache + SSM 两类状态对象,缓存、路由与内存编排都会更复杂。

02 推理技术创新的

系统化布局(Overview)

为了将上述“趋势”转化为具体的研究课题,我们将 LLM 推理系统的问题空间收敛为一个分层的三层架构:覆盖了从底层缓存管理、中间层引擎优化到上层分布式调度的完整链路。在 2025 年,我们团队在这三个层级上进行了全面的系统化布局。

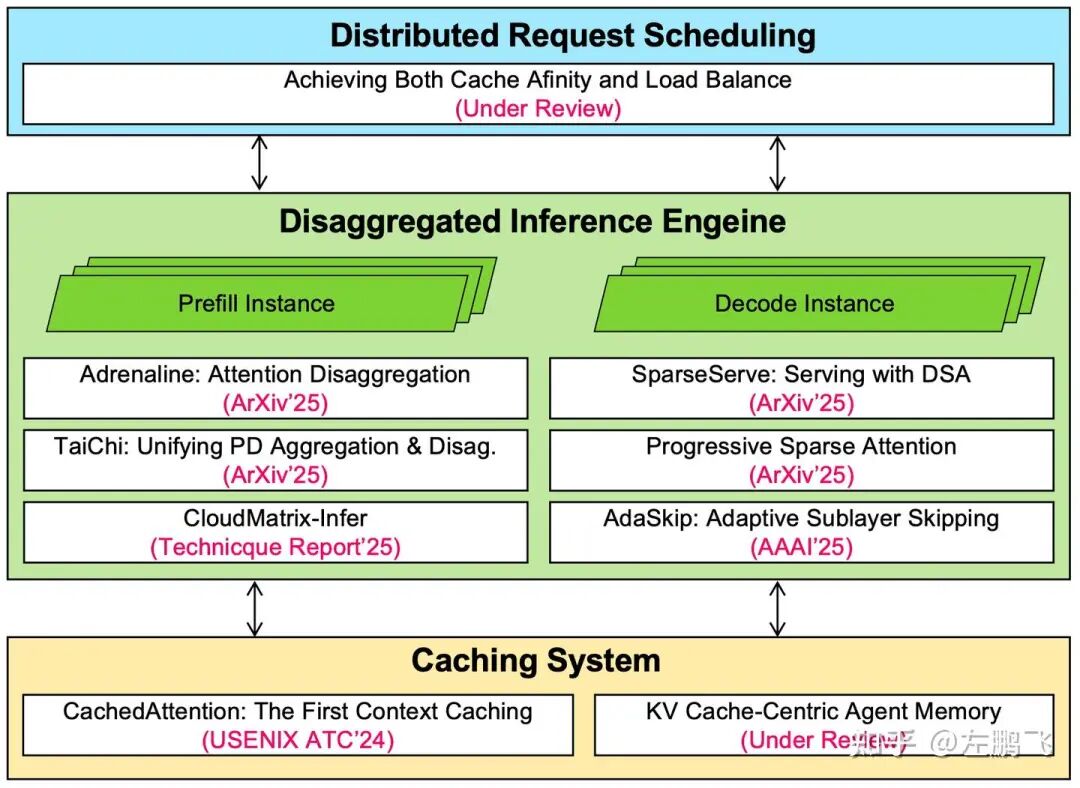

如图 2 所示,我们的研究覆盖了完整链路:

1. Distributed Scheduling Layer(分布式调度层):负责全局的请求调度。其核心挑战是,在有状态的服务系统中,如何平衡局部性(Locality)与均衡性(Balance)。我们提出了 DualMap(Achieving Both Cache Affinity and Load Balance),通过The Power of Two Choises 双重哈希和状态感知路由,打破了传统调度算法非此即彼的困局 。

2. Inference Engine Layer(推理引擎层):负责高效执行模型计算。针对 PD 分离后的资源利用率问题,我们推出了Adrenaline (Attention Disaggregation),利用Attention 分离和混部同时提升 P 和 D 的资源利用率;以及 TaiChi,统一了 P/D 聚合与分离的架构之争,并且压榨 SLO 过满足请求的资源以提升整体吞吐。此外,针对动态稀疏注意力 (DSA) 模型的显存容量瓶颈,我们推出了 SparseServe,Scaling Batch Size 来提升 Decode 吞吐。

3. Caching System Layer(缓存系统层):负责 KV Cache的存储与复用。针对这一层,我们之前在USENIX ATC ‘24上发表了 CachedAttention,这应该是业界首个顶会发表的 Context Caching 系统,并首次提出使用 Hierarchical Storage 来存储 KV Cache。2025 年,我们针对 Agent 场景,进一步演进出了 KV Cache-Centric Agent Memory (MemArt),颠覆 Agent Memory 的表征形态。

这三层架构通过紧密的垂直协同(Vertical Co-design),共同构成了我们对推理系统技术创新的答案。

03 2025年度五大代表工作详解

接下来,我会简单介绍下这五个代表性工作的内容,感兴趣的同学可以进一步阅读论文原文。

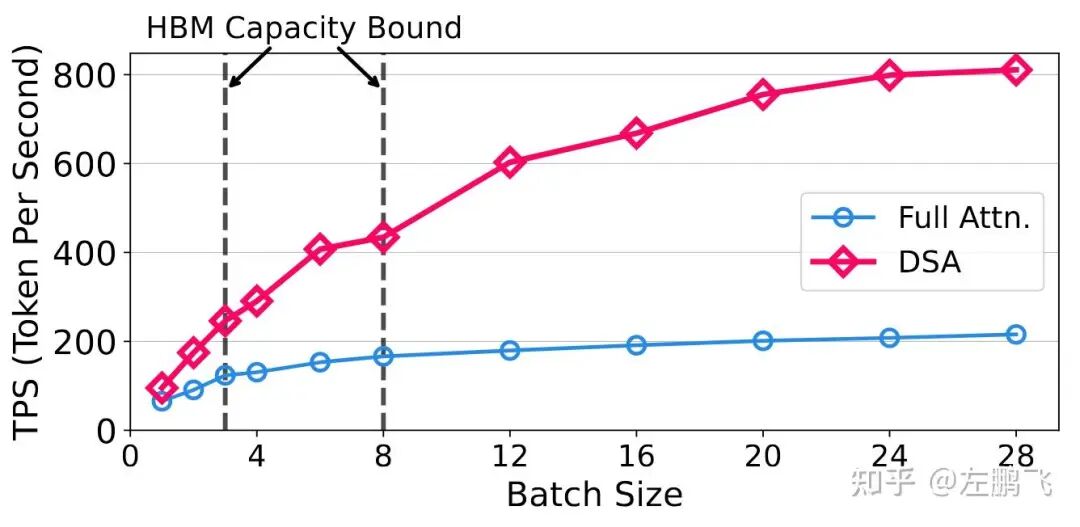

1. SparseServe: 打破动态稀疏注意力的“容量墙”

论文链接:https://arxiv.org/abs/2509.24626v1

动机:引入动态稀疏注意力(DSA)虽然大幅降低了 Attention 的计算量和单步访存需求,但系统面临着严峻的“存储效率悖论”:为了保证低解码时延,大量未被选中的“冷” Token 对应的 KV Cache 依然必须驻留在 HBM 中。这直接导致系统的瓶颈从“算力/带宽”转移到了“显存容量”。如图 3 所示,对于 Full Attention,受限于显存带宽墙(Memory Wall),单纯增加 Batch Size 对解码吞吐量的提升已趋于饱和(曲线平缓);而对于 DSA,得益于其低带宽需求,增加 Batch Size 本应能带来端到端吞吐量的线性飞跃。遗憾的是,现实中 Batch Size 往往过早地被 HBM 的物理容量硬性截断(Capacity Bound),导致 DSA 极高的理论吞吐上限无法在生产环境中兑现。

核心 Idea:将这些利用率低下的 KV Cache 卸载到 DRAM(系统内存)中可以释放 HBM容量,从而允许更大的并行 Batch Size。然而,实现这种 HBM-DRAM 分级存储带来了新的挑战,包括碎片化的 KV Cache 访问、HBM 缓存竞争以及混合批处理(Hybrid Batching)带来的高 HBM 需求,这些问题在之前的工作中尚未得到解决。

为了解决这些挑战,我们提出了 SparseServe,这是一个旨在通过高效的 HBM-DRAM 分级管理来释放 DSA(动态稀疏注意力)并行潜力的 LLM 推理技术。SparseServe 引入了三项关键创新来解决上述挑战:1)碎片感知 KV Cache 传输:通过 GPU 直接加载 (FlashH2D) 和 CPU 辅助保存 (FlashD2H) 加速 HBM-DRAM 之间的数据移动;2)工作集感知 Batch Size 控制:根据实时工作集(Working Set)估计调整 Batch Size,以最大程度减少 HBM 缓存颠簸(Thrashing);3)分层 Prefill(Layer-segmented Prefill):将 Prefill 阶段的 HBM 占用限制在单层范围内,从而即使在处理长 Prompt 时也能实现高效执行。

效果:通过打破容量墙,SparseServe 使得大模型推理的 TTFT(首字延迟)降低了 9.26倍,吞吐量提升了 3.14倍。

2. Adrenaline: 为推理系统注入“肾上腺素”

论文链接:https://arxiv.org/abs/2503.20552

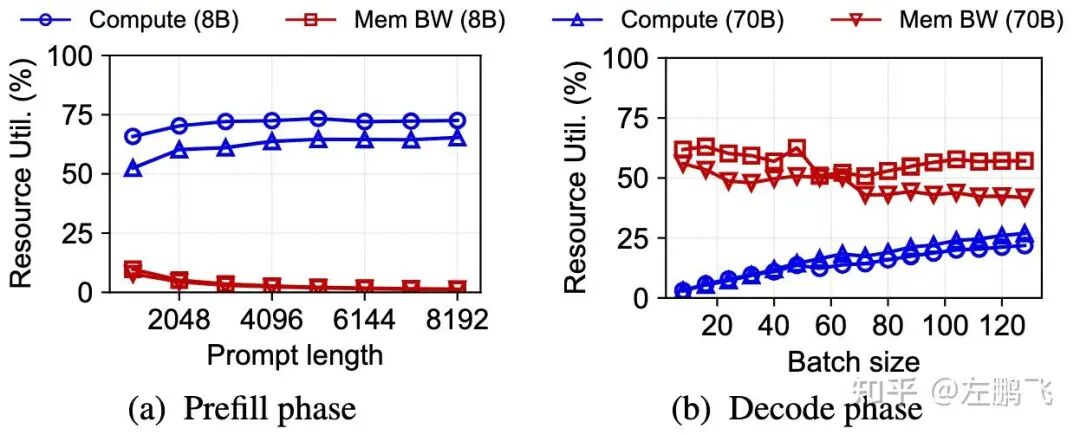

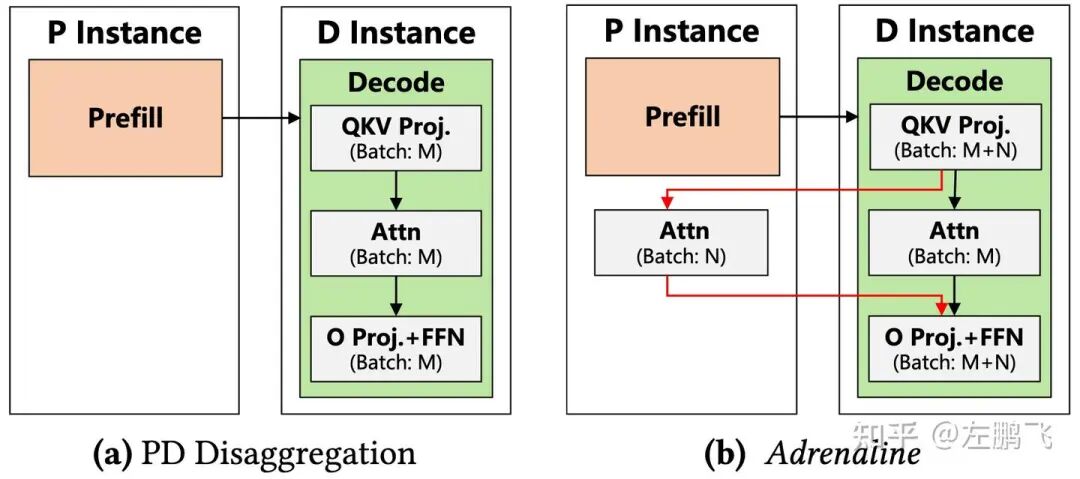

动机:在主流的 PD 分离架构中,我们面临着严峻的资源错配问题。如图 4 所示,Decode 节点受限于显存带宽,其昂贵的算力资源往往处于“饥饿”状态,无法被喂饱;与此同时,Prefill 节点在处理计算密集型的 Prefill 任务时,其充裕的显存带宽却长期处于闲置状态。然而,物理分离导致 Decode 无法跨节点“借用”Prefill 的显存带宽,Prefill 也无法“支援”Decode 的算力需求。这种割裂使得 Prefill 和 Decode 节点之间形成了一座座无法逾越的“资源孤岛”(Resource Silos),导致集群整体的资源利用率难以突破瓶颈。

核心 Idea:为了解决这一结构性失衡,我们提出了 Adrenaline,这是一个实现了“流体资源池化(Fluid Resource Pooling)”的推理服务系统。受到生物学中渗透作用的启发,即溶剂自然地穿过半透膜以平衡浓度,Adrenaline 允许内存密集型的 Decode Attention 计算(及其关联的 KV Cache)渗透穿过 Prefill 和 Decode 实例之间的物理边界。

通过让 Decode Attention 任务从资源受限的 Decode 节点自然流向显存富余的Prefill 节点,Adrenaline 有效地将 Prefill GPU 中未充分利用的 HBM 转化为 Decode 任务的扩展资源池。这种机制成功平衡了集群内的资源压力:它在“喂饱”Prefill 节点闲置 HBM 容量和带宽的同时,解锁了 Decode 节点上更大的 Batch Size。另外, Adrenaline通过低延迟解码同步、资源高效的 Prefill 混部以及感知 SLO 的卸载调度,克服了跨实例延迟和干扰的挑战。

效果:与最先进的 PD 分离系统相比,Adrenaline 将不同资源的利用率提高了 1.05 倍至 6.66 倍,并在满足 SLO 约束的前提下将整体推理吞吐量提升了 2.04 倍。

3. TaiChi: 统一架构的太极之道

论文链接:Prefill-Decode Aggregation or Disaggregation? Unifying Both for Goodput-Optimized LLM Serving

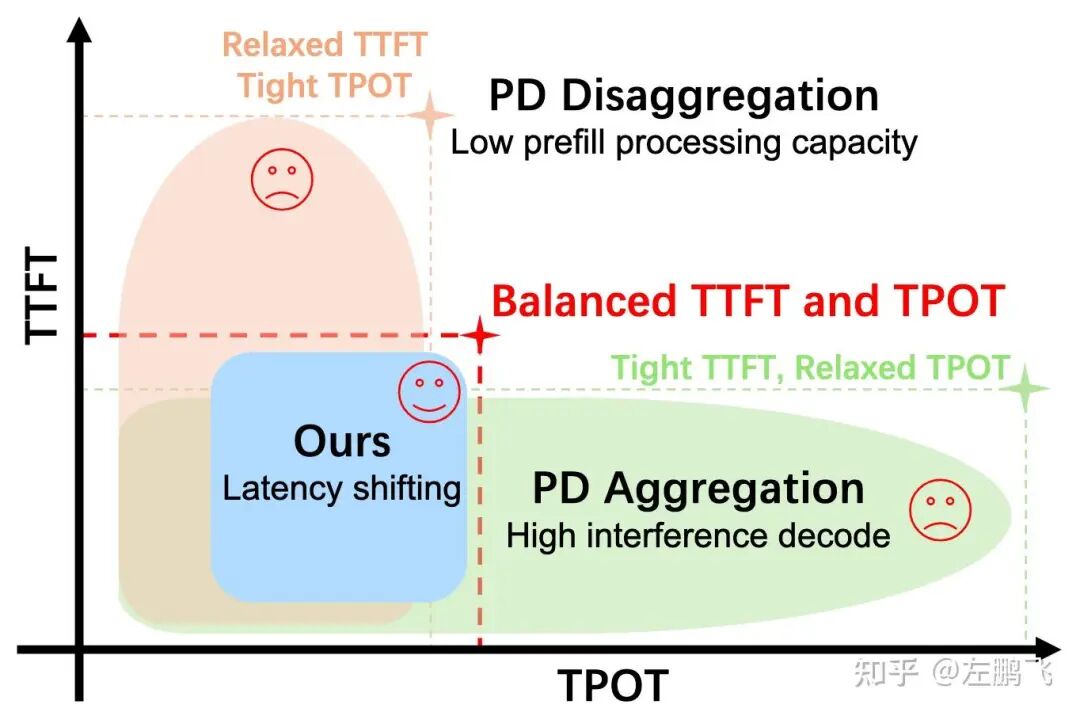

动机:LLM推理领域存在着一场架构之争:一方是 Prefill-Decode (PD) 聚合(将 Prefill 和 Decode 共置于同一 GPU),另一方是 PD 分离(将它们部署在不同的 GPU 上)。我们系统地比较了这两种设计在不同 TTFT 和 TPOT SLO 下的表现,发现:当 TTFT SLO 严格而 TPOT SLO 宽松时,聚合架构胜出;而在相反的条件下,分离架构更优。然而,在平衡的 TTFT/TPOT SLO 下,两者在满足 SLO 的有效吞吐量(Goodput)方面都表现出显著的次优性,揭示了一个此前未被定性的 Goodput Gap,如图 6 所示。

核心Idea:我们将这一Goodput Gap归因于未被充分利用的延迟余量(Latency Slack):许多请求在远低于其 TTFT/TPOT SLO 的时间内完成,而其他请求则面临违约风险,然而现有系统仅暴露了统一的、阶段级的调节旋钮,无法跨请求和阶段重新分配这些余量。因此,我们提出延迟挪移(Latency Shifting)作为 LLM 服务的设计原则:将 TTFT/TPOT SLO 余量视为一种核心资源,可以对其进行策略性重新分配以最大化 Goodput。

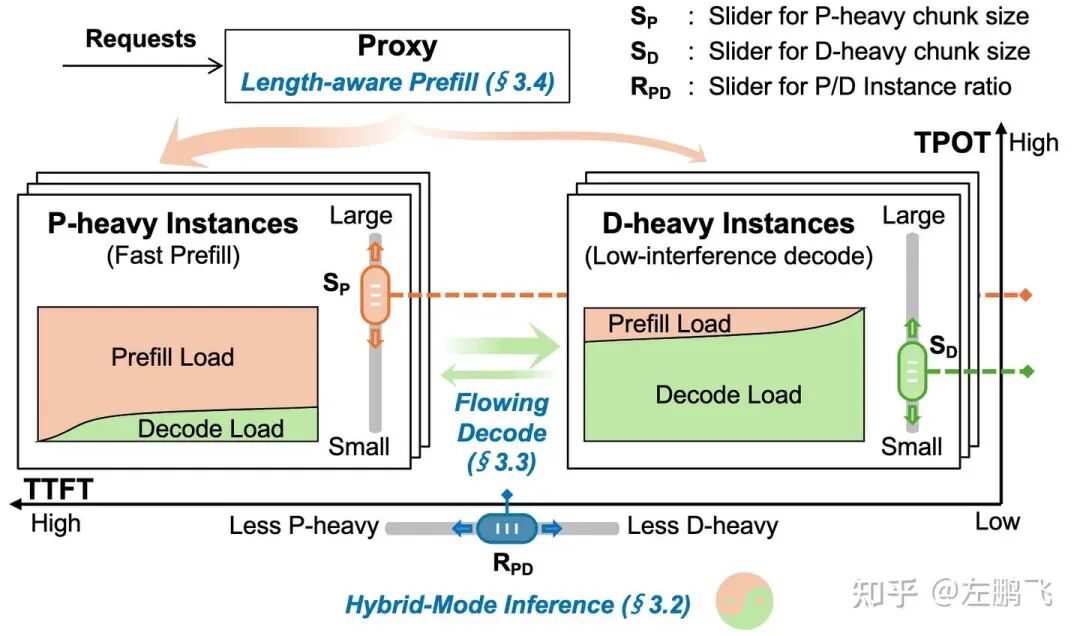

为了实现这个 Idea,我们提出了 TaiChi,这是一个通过混合模式推理(Hybrid-mode Inference)架构和两个请求级调度器来实现延迟挪移的 LLM 服务系统。混合模式通过在异构的 Prefill-heavy 和 Decode-heavy 实例上,结合“聚合批处理”与“逐请求阶段解耦”,填补了 2D PD 设计空间中的空白。在此之上,流动解码(Flowing Decode) 在批处理解码和未知输出长度的约束下对 TPOT 进行整形,而 感知长度的预填充(Length-aware Prefill) 则根据 TTFT 预测,选择性地“降级”那些余量丰富的 Prefill 请求。最后,我们通过三个滑块的设计,使得 TaiChi 可以用一个架构统一 PD 聚合、PD 分离和混合模式推理,如图 7 所示。

效果:与最先进的 PD 聚合和分离系统相比,TaiJi 将 Goodput 提升了最高 40%,同时将 P90 TTFT 降低了最高 5.3 倍,将 P90 TPOT 降低了最高 1.6 倍。

4. DualMap: 鱼与熊掌兼得的分布式调度

论文链接:待补充

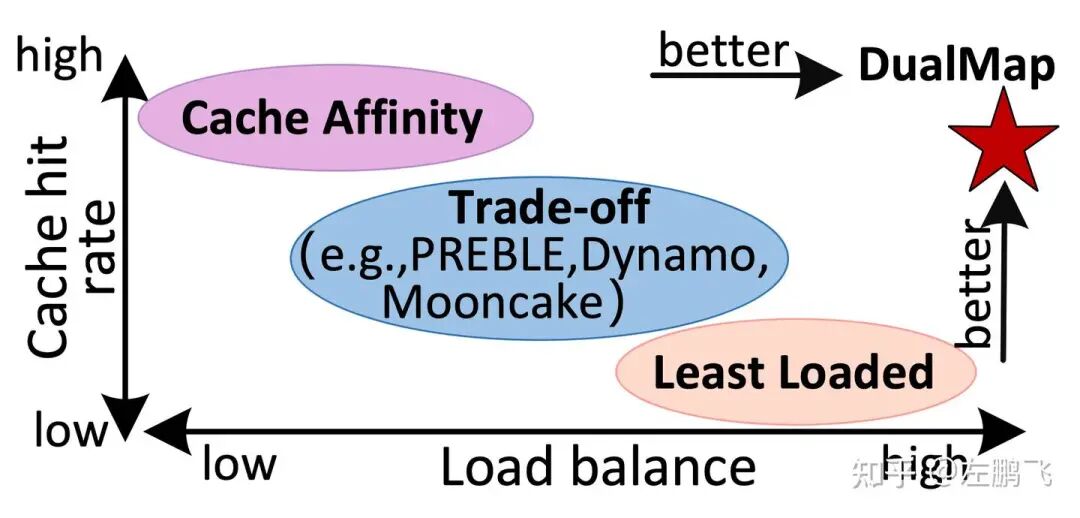

动机:在LLM推理服务中,跨请求复用 Prompt 的键值(KV)缓存是降低TTFT和服务成本的关键技术。缓存亲和性调度(Cache-affinity Scheduling)旨在将具有相同 Prompt 前缀的请求共置以最大化 KV Cache 复用,但这往往与旨在将请求均匀分布到计算实例上的负载均衡调度(Load-balancing Scheduling)发生冲突。现有的调度器难以调和这种权衡(Trade-off),因为它们通常在单一的映射空间内运作,只能对一部分请求应用亲和性路由,而对另一部分应用负载均衡,缺乏一个能同时实现这两个目标的统一方案。

核心 Idea:为了克服这一局限,我们提出了DualMap,一种用于分布式 LLM 服务的双重映射调度策略,它能同时实现缓存亲和性与负载均衡,如图 8 所示。DualMap 的核心思想是基于请求的 Prompt,利用两个独立的哈希函数将每个请求映射到两个候选实例,然后根据当前的系统状态智能地择优录取。这种设计利用 The Power of Two Choices,既增加了共享前缀请求被共置的概率,又确保了不同前缀的请求能均匀分散在集群中。

为了使 DualMap 在动态且倾斜的真实工作负载下保持鲁棒性,我们引入了三项技术:

1. 感知 SLO 的请求路由(SLO-aware Request Routing):优先考虑缓存亲和性,但当 TTFT 超过 SLO 时切换为感知负载的调度,在不牺牲缓存复用的前提下增强负载均衡;

2. 感知热点的再平衡(Hotspot-aware Rebalancing):动态地将请求从过载实例迁移到低负载实例,从而消除热点并重平衡系统;

3. 轻量级双哈希环扩缩容(Lightweight Dual-hash-ring Scaling):利用双哈希环映射支持快速且低开销的实例扩缩容,避免了昂贵的全局重映射。

效果:与最先进的工作(SOTA)相比,在相同的 TTFT SLO 约束下,DualMap 将系统的有效请求容量(Effective Request Capacity)提升了高达 2.25 倍。

5. KVCache-Centric Memory (MemArt): 面向 Agent 的原生记忆

论文链接:待补充

动机:LLM 智能体正在成为把基础模型用于复杂真实工作流的新范式,例如科研探索、编程助手和自动化任务规划。与单轮提示或短对话机器人不同,智能体往往运行数小时到数天,包含数十到数百次迭代调用,持续累积的上下文很快会超过模型上下文窗口。为解决这一扩展性瓶颈,业界开始引入外部记忆(Memory)系统,用于存储并按需检索历史信息,以维持长时程任务中的效率、准确性与鲁棒性。

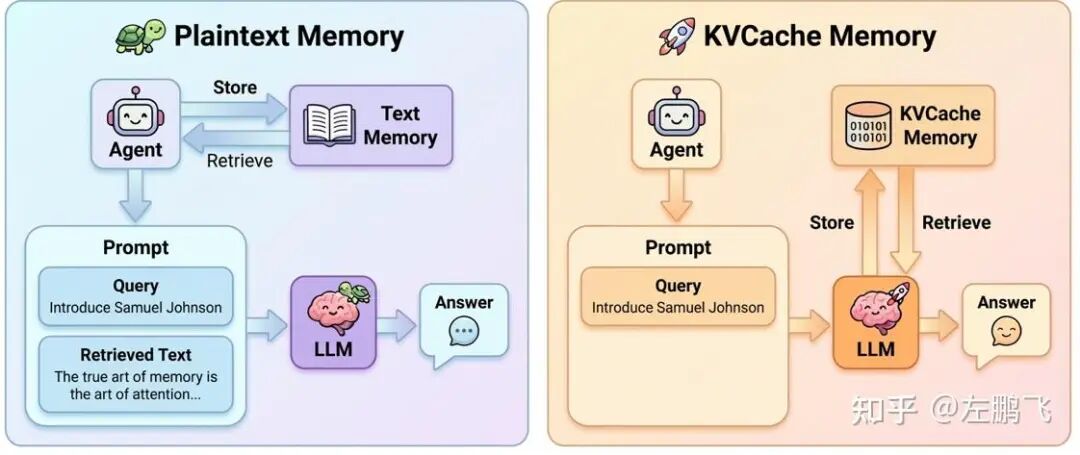

目前主流记忆系统多采用“明文记忆”:把历史对话切分/总结为条目,再用向量库或图结构检索。这种方式有两点根本问题:其一,摘要与相似度检索难以保留多轮交互的完整语义依赖,容易漏掉关键信息或带入噪声,效果往往不如全上下文推理;其二,离散化的记忆条目会打断提示前缀的连续结构,破坏推理引擎依赖的前缀缓存,从而削弱性能与效率收益。

核心Idea:我们提出 MemArt,一种新的记忆范式:从明文记忆转向以 KV Cache 为中心的记忆,以同时提升推理效果与效率。MemArt将历史上下文直接存成可复用的 KV 块,并在隐空间中计算当前提示与各 KV 块的注意力分数来检索相关记忆,如图 9 所示。它带来三点优势: (1) 高保真检索:检索与模型注意力机制对齐,语义更准; (2) 高效率:命中的 KV 块可在 prefill 直接复用,避免重复处理 Token,降低时延与开销;(3) 易集成:即插即用,无需改模型权重或结构。

实现 KVCache-centric Memory 仍有两大挑战: 第一,记忆库变大后,如何避免全量扫描仍能准确检索;第二,检索到的 KV 块通常是非连续的且带原始位置信息,直接拼接会造成位置不一致,影响输出质量。为此,MemArt为每个 KV 块构建压缩代表 Key,用于快速筛选;再用多 Token 聚合策略综合所有提示 Token 的注意力分数,提高相关性。最后通过解耦的位置编码机制校验并调整检索块的位置,使其能安全、连贯地复用到当前上下文中。

效果:相比最先进的基于明文的记忆方法,MemArt的推理准确率提升了 11.8%–39.4%,并接近全上下文推理的性能。更关键的是,相比基于明文的记忆方法,它将 Prefill Token 数量降低了 91–135倍。

这些结果表明,以 KVCache 为中心的记忆(KVCache-centric Memory)有望成为构建高准确性、高效率长上下文 LLM 智能体的关键基础。与此同时,它也带来一系列系统实现挑战,尤其是记忆规模扩大后的存储容量与成本压力:需要结合存储分级(HBM/DRAM/SSD)、高效的缓存管理策略,以及 KV Cache 压缩与淘汰机制等手段,才能在工程上可持续落地。对这一方向感兴趣的同学,可以沿着“更低成本的 KV 级记忆管理”这条路线继续深入研究。

04 结语

2025 年,我们团队的研究主线非常清晰:不再局限于单一算子或单一模型的优化,而是以端到端视角推进系统架构的全栈创新,去推倒阻碍推理效率的“资源墙”与“效率墙”。

从 SparseServe 对动态稀疏注意力(DSA)显存容量瓶颈的突破 ,到 Adrenaline 对 P/D 分离后“资源孤岛”的巧妙弥合 ;从 TaiChi 终结聚合与分离的架构路线之争 ,到 DualMap 在数学层面完美调和缓存亲和性与负载均衡的矛盾 ,再到 MemArt 将 Agent 记忆从应用层文本下沉为系统级原语 。这些工作共同构成了一套全新的的大模型推理基础设施。

Looking Forward to 2026:

如果说 2025 年是系统架构重塑的一年,那么 2026 年将是“模型演进与应用爆发倒逼系统范式跃迁”的一年。

我们预见,模型架构将走向极致的动态稀疏化,MoE 与稀疏/线性注意力等异构计算图的深度融合,将使推理负载的动态性达到前所未有的高度;多模态能力的全面爆发,意味着输入流将从文本扩展至音视频流,带来数倍于当前的异构上下文压力;而 Agent 应用的进一步井喷,将推动推理从单次交互走向长时程、复杂状态的任务编排。另一个值得关注的方向是 Continual Learning,它有望成为未来主流,但短期内距离商用仍存在算法突破的门槛。

面对这些变革,我们将继续在“不确定性中寻找确定性”:把模型侧的极致稀疏转化为系统侧可预测、可兑现的 SLO-goodput;把多模态的异构输入收敛为统一可调的调度与资源编排原语;把 Agent 的复杂状态内化为可复用、低成本、可治理的系统级记忆。我们期待在新的战场上,推动推理基础设施从“高性能”走向“高适应、高可靠、可持续扩展”,为下一代 AI 应用提供真正可规模化的底座。